Dans cet article:

Google Edge TPU - Qu'est-ce que c'est ? Et comment fonctionne-t-il ?

Assured Systems fournit une variété de produits dotés de Google Edge TPU pour une large gamme d'applications. Découvrez ce qu'est Google Edge TPU, comment il fonctionne et quels sont ses avantages pour vous.

L'IA (Intelligence Artificielle) est une technologie qui permet à un ordinateur de penser ou d'agir d'une manière plus "humaine" en absorbant des informations de son environnement et en décidant de sa réponse sur la base de ce qu'il apprend ou de ce qu'il sent - et des applications grand public aux applications d'entreprise, l'IA est aujourd'hui omniprésente.

L'IA (Intelligence Artificielle) est une technologie qui permet à un ordinateur de penser ou d'agir d'une manière plus "humaine" en absorbant des informations de son environnement et en décidant de sa réponse sur la base de ce qu'il apprend ou de ce qu'il sent - et des applications grand public aux applications d'entreprise, l'IA est aujourd'hui omniprésente.

Avec l'explosion du nombre d'appareils connectés, combinée à une demande de confidentialité, de faible latence et de contraintes de bande passante, les modèles d'IA formés dans le nuage doivent de plus en plus être exécutés à la périphérie - ce qui signifie simplement que l'appareil peut exécuter l'application d'IA de manière indépendante sans avoir à renvoyer de données à un serveur utilisant une connexion internet.

Qu'est-ce que Google Edge TPU ?

Google Edge TPU est un ASIC (circuit intégré à application spécifique - optimisé pour exécuter un type d'application spécifique) conçu par Google pour exécuter des applications d'intelligence artificielle en périphérie. Il offre des performances élevées pour un encombrement physique et énergétique réduit, ce qui permet le déploiement d'une IA de haute précision à la périphérie.

Google Edge TPU complète Cloud TPU et les services Google Cloud pour fournir une infrastructure matérielle et logicielle de bout en bout, du nuage à la périphérie,  , afin de faciliter le déploiement de solutions basées sur l'IA pour les clients.

, afin de faciliter le déploiement de solutions basées sur l'IA pour les clients.

Mais comment ?

Eh bien, The Edge TPU vous permet de déployer une inférence ML de haute qualité à la périphérie, en utilisant divers produits de prototypage et de production de Coral.

La plateforme Coral pour le ML à la périphérie complète le Cloud TPU et le Cloud IoT de Google pour fournir une infrastructure de bout en bout (du nuage à la périphérie, matériel et logiciel) afin de faciliter le déploiement des solutions basées sur l'IA des clients. La plateforme Coral fournit une boîte à outils complète pour les développeurs afin qu'ils puissent compiler leurs propres modèles ou recycler plusieurs modèles d'IA de Google pour l'Edge TPU, en combinant l'expertise de Google en matière d'IA et de matériel.

Google Edge TPU complète les CPU, GPU, FPGA et autres solutions ASIC pour l'exécution de l'IA à la périphérie.

L'informatique dématérialisée contre l'informatique en périphérie

Exécuter du code dans le nuage signifie que vous utilisez les CPU, GPU et TPU d'une entreprise qui les met à votre disposition via votre navigateur. Le principal avantage de l'exécution de code dans le nuage est que vous pouvez affecter la puissance de calcul nécessaire à ce code spécifique (l'entraînement de grands modèles peut nécessiter beaucoup de calculs)

La périphérie est à l'opposé du nuage. Cela signifie que vous exécutez votre code sur place (ce qui signifie essentiellement que vous êtes en mesure de toucher physiquement l'appareil sur lequel le code s'exécute). Le principal avantage de l'exécution du code en périphérie est qu'il n'y a pas de latence du réseau. Comme les appareils IoT génèrent généralement des données fréquentes, l'exécution du code en périphérie est parfaite pour les solutions basées sur l'IoT

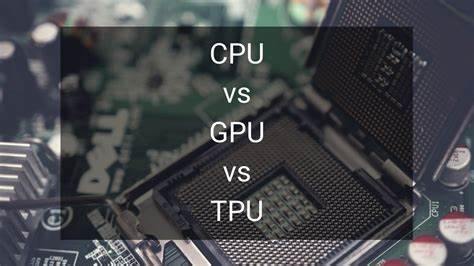

Quelle est la différence entre TPU, CPU et GPU ?

Une TPU (Tensor Processing Unit) est un autre type d'unité de traitement comme un CPU ou un GPU. Il existe cependant de grandes différences entre ces deux types d'unités, la plus importante étant que la TPU est un ASIC. Et comme vous le savez probablement déjà, les CPU et les GPU ne sont pas des ASIC, car ils ne sont pas optimisés pour un type d'application spécifique.

Une TPU (Tensor Processing Unit) est un autre type d'unité de traitement comme un CPU ou un GPU. Il existe cependant de grandes différences entre ces deux types d'unités, la plus importante étant que la TPU est un ASIC. Et comme vous le savez probablement déjà, les CPU et les GPU ne sont pas des ASIC, car ils ne sont pas optimisés pour un type d'application spécifique.

Puisque nous comparons les CPU, les GPU et les TPU, examinons rapidement comment ils effectuent respectivement les opérations de multiplication et d'addition en fonction de leur architecture :

- Un CPU effectue l'opération de multiplication-addition en lisant chaque entrée et chaque poids dans la mémoire, en les multipliant avec son ALU (Arithmetic Logic Unit), en les réécrivant dans la mémoire et enfin en additionnant toutes les valeurs multipliées. Les unités centrales de traitement modernes sont renforcées par un cache massif, une prédiction de branchement et une fréquence d'horloge élevée sur chacun de leurs noyaux. Tous ces éléments contribuent à réduire le temps de latence du CPU.

- Un GPU n'utilise cependant pas les fonctions sophistiquées qui réduisent la latence. Il doit également orchestrer ses milliers d'ALU, ce qui réduit encore la latence. En bref, les GPU augmentent considérablement leur débit en parallélisant leurs calculs en échange d'une augmentation de leur temps de latence.

- En revanche, le fonctionnement d'une TPU est très différent. Ses UAL sont directement connectées les unes aux autres sans utiliser la mémoire. Elles peuvent directement se transmettre des informations, ce qui réduit considérablement le temps de latence.

En conclusion, la TPU Edge effectue l'inférence plus rapidement que toute autre architecture d'unité de traitement. Elle n'est pas seulement plus rapide, elle est aussi plus écologique grâce à l'utilisation de la quantification et à la réduction des opérations de mémoire.